L3T - Lehrbuch für Lernen und Lehren mit Technologien

L3T - kurz für Lehrbuch für Lernen und Lehren mit Technologien - ist eine Open Educational Resource (OER) und in der aktuell gültigen Fassung über dieses Bookstack-Wiki abrufbar.

Gerade die Welt der Computer, des Internets bzw. der modernen Technologien ist besonders schnelllebige. So stehen gerade Bücher zu diesem Thema im ständigen Kampf, aktuell gehalten zu werden, um relevant zu sein und auch zu bleiben. Um diesem Trend entgegenzuwirken, soll das L3T-Lehrbuch gemeinsam aktuell gehalten werden. Jeder ist eingeladen, mitzuwirken, das Buch zu aktualisieren, zu erweitern und zu verbessern.

Um mitzuwirken gibt es neben dem Bookstack als Frontend ein öffentliches Github-Repo, in welchem die Inhalte des Buches angepasst werden können.

Das Repository ist über folgenden Link abrufbar: https://github.com/ed-tech-at/L3T

- Einleitung

- L3T – die zweite Auflage

- Was ist denn eigentlich „L3T“?

- Zielgruppe und Themenfeld

- Inhalt im Überblick

- Zugänge zum Lehrbuch

- Gliederung des Lehrbuchs

- Gestaltung der Kapitel

- Weitere Materialien zu den Kapiteln

- L3T 2.0 – Organisation, Ablauf und Neues

- Projektpartner/innen und Unterstützer/innen

- Danke, danke, danke!

- Und so geht es weiter

- Ach ja: Nobody is perfect

- Einführung

- Einleitung: Lernen und Lehren mit Technologien

- Grundbegriffe im Themenfeld

- Lernen und Lehren

- Szenarien des Einsatzes von Technologien

- Diskussion: „E-Learning 2.0“

- Ein interdisziplinäres Forschungsfeld

- Ausblick: Erweiterung der Lern- und Lehrmöglichkeiten

- Literatur

- Von der Kreidetafel zum Tablet

- Einleitung

- Kreidetafel

- Whiteboard

- Interaktives Whiteboard

- Diaprojektor

- Tageslichtprojektor

- Epiprojektor (Episkop) / Visualizer

- Fernseher, Monitor, Videorekorder, DVD-Player

- Touchscreen

- Videoprojektor

- PC, Laptop und Netbook

- Interactive Pen Display

- Papershow

- Smartphone

- Tablet

- Fazit

- Literatur

- Die Geschichte des WWW

- Robnett Licklider, Ted Nelson und Sam Fedida

- Die Grundidee des BTX

- Erweiterungen des BTX

- Der Durchbruch des WWW und wie die USA die Führung übernehmen

- Literatur

- Hypertext

- Vorkommen

- Ein Beispiel

- Geschichte

- Erfolgreich verbreitete Systeme

- Das World Wide Web und die Browser

- Strukturmerkmale von Hypertext

- Werkzeuge

- Zur weiteren Entwicklung von Hypertext

- Literatur

- Geschichte des Fernunterrichts

- Einführung: Mediengestützes Lernen und Fernlernen

- Generationen technologischer Innovationen

- Zur Entwicklung des technologiegestützen Lernens heute

- Literatur

- Informationssysteme

- Grundlagen

- Werkzeuge zum Lernen und Lehren

- Autorinnen- und Autorenwerkzeuge und Lerncontentmanagementsysteme: Was wird zur Erstellung von Lernmaterialien benötigt?

- Lernmanagementsysteme: Lernende und Kurse verwalten

- Lernen mit Informationssystemen: Zusammenspiel und Problempunkte

- Literatur

- Webtechnologien

- Einleitung

- Grundlegende Technologien

- Das World Wide Web (WWW)

- Einführung in die Applikationsentwicklung für das Web

- Vor Gebrauch gut schütteln — Syndikation und Integration

- Aktuelle Trends in der Entwicklung von Webanwendungen

- Literatur

- Multimediale und interaktive Materialien

- Die Mischung macht’s – Überlegungen zu Beginn

- Über Bilder, Audio, Video und Animationen zu interaktiven Lernmaterialien

- Datenkompression bei multimedialen Materialien

- Aktuelle Programme zur Erstellung von Lernmaterialien und deren Einbindung in Lernmanagementsysteme

- Fazit und Kontrollfragen

- Literatur

- Standards für Lehr- und Lerntechnologien

- Einführung

- Metadaten

- Standards für Inhaltsformate

- Standards zur Beschreibung von Lehr- und Lernprozessen

- Zusammenfassung und Ausblick

- Literatur

- Human-Computer-Interaction

- Didaktisches Handeln

- Lerntheorien – vom Lernen zum Lehren?

- Didaktisches Design – vom Lehren zum Lernen?

- Eine Handlungslogik für die Gestaltung didaktischer Szenarien

- Lerntheorien und Didaktisches Design – ein Fazit

- Literatur

- Medienpädagogik

- Einführung

- Strömungen der Medienpädagogik

- Forschungsfragen und -methoden der Medienpädagogik

- Aufgabe von Medienpädagogik

- Medienpädagogik – immer noch aktuell?

- Literatur

- Systeme im Einsatz

- Einleitung

- Webbasierte Trainingssysteme (WBT)

- Lernmanagementsysteme

- E-Portfolio-Systeme

- Persönliche Lernumgebungen (PLE)

- Massive Open Online Courses (MOOCs)

- Ausblick

- Literatur

- Kommunikation und Moderation

- Die Bedeutung von Kommunikation im Lernprozess

- Computervermittelte Kommunikation

- Lerngemeinschaften im Web

- Kommunikationsformen beim Online-Lernen und Moderation von Online-Lerngemeinschaften

- Fazit

- Literatur

- Forschungszugänge und -methoden

- Einleitung

- Unterschiedliches Verständnis von Forschung und Forschungsmethoden

- Drei unterschiedliche Forschungszugänge

- Qualitative, quantitative und Methodenmix-Verfahren

- Ausgewählte Forschungsmethoden im Forschungsprozess

- Zur Wahl geeigneter Forschungsmethode

- Ausblick: Typische Herausforderungen

- Literatur

- Planung und Organisation

- Bildungszyklus als Ordnungsraster

- Bildungsbedarf bestimmen

- Planung und Konzeption didaktischer Interaktionen

- Nachbereitung des Bildungsprozesses

- Evaluation des Bildungsprozesses

- Zentrale Erkenntnisse

- Literatur

- Literatur und Information

- Einleitung

- Vorbereitung

- (Online-) Recherche

- Evaluation der Ergebnisse

- Weiterverarbeitung

- Digitale Werkzeuge zum Speichern und Wiederfinden gefundener Informationen

- Nutzen und Grenzen von Suchmaschinen

- Fazit

- Literatur

- Die „Netzgeneration“

- Das Konzept einer „Netzgeneration“ – zentrale Aussagen

- Mythos „Netzgeneration“ – zentrale Kritikpunkte am Konzept

- Ergebnisse empirischer Studien – ein weitaus differenzierteres Bild

- Konsequenzen für das Lehren und Lernen mit Technologien – Diversität unterstützen

- Zusammenfassung der zentralen Erkenntnisse

- Literatur

- Multimedia und Gedächtnis

- Einleitung

- Gedächtnisprozesse

- Begrenzte kognitive Ressourcen

- Instruktionale Prinzipien zum multimedialen Lernen

- Literatur

- Mobiles und ubiquitäres Lernen

- Definitionen

- Mobile Lerntechnologie

- Mit mobiler Technologie lernen

- Allgegenwärtige Lernunterstützung

- Didaktische Aspekte: Lernen im Kontext

- Klassifikation und Anwendungsbeispiele

- Zentrale Erkenntnisse

- Literatur

- Prüfen mit Computer und Internet

- Hintergrund

- Didaktik: Formen und Funktionen von Prüfungen

- Methodik: Aufgabentypen in Lernfortschrittkontrollen

- Organisation: Prozesse computerunterstützter Prüfungen

- Technik: Klassifizierung von E-Assessment-Systemen

- Zusammenfassung

- Literatur

- Blogging und Microblogging

- Einführung

- Begriffe und Definitionen

- Lernen mit Micro-/Blogs

- Didaktische Einsatzszenarien

- Micro-/Blogging in der Forschung

- Literatur

- Vom Online-Skriptum zum E-Book

- Online-Unterlagen

- Exkurs: SCORM - Der Versuch einer Vereinheitlichung von Online-Inhalten

- Interaktion und Vernetzung der Inhalte

- E-Reader-Formate und HTML5

- Zentrale Erkenntnisse

- Literatur

- Educasting

- Was sind Educasts?

- Vorgehen bei der Erstellung von Educasts

- Lern-/Lehrtheoretische Verortung

- Didaktische Gestaltungsmöglichkeiten für den Einsatz von Educasts

- Projekte und Beispiele

- Bildungskontexte für den Einsatz von Educasts

- Fazit

- Literatur

- Game-Based Learning

- Begriff und Geschichte

- Grundüberlegungen

- Potenziale und Herausforderungen

- Zusammenfassung und zentrale Erkenntnisse

- Ausblick: Durchdringt uns die Gamification?

- Literatur

- Einsatz kollaborativer Werkzeuge

- Web-Werkzeuge für kollaboratives Arbeiten

- Schreiben kurzer Texte

- Schreiben komplexer Texte

- Sammeln und Strukturieren von Ideen

- Gemeinsames Sammeln und Verschlagworten von Informationen

- Synchrone Online-Treffen

- Dokumentieren und Kommunizieren von Gruppenprozessen

- Dateiablagedienste mit Kollaborationsfunktionen

- Benutzerkonten, Kosten, Rechtliches

- Zusammenfassung und Ausblick

- Literatur

- Offene und partizipative Lernkonzepte

- Charakteristik von offenen und partizipativen Lernarrangements

- E-Portfolios

- MOOCs (‚Massive Open Online Courses’)

- Flipped Classroom

- Fazit

- Literatur

- Qualitätssicherung im E-Learning

- Qualität für digitale Lernwelten: Von der Kontrolle zur Partizipation und Reflexion

- Konzepte und Methoden zur Qualitätsentwicklung in digitalen Lernwelten

- „Löcher in der Gartenmauer“: Neue Lern- und Qualitätskultur für E-Learning

- Einleitung

- Literatur

- Offene Lehr- und Forschungsressourcen

- Einleitung

- Traditionelle wissenschaftliche Publikationen und der Einfluss der Digitalisierung

- Die Open-Access-Bewegung

- Bildungsressourcen und der Einfluss von Internet und Digitalisierung

- Open Educational Resources: Frei verwendbare Lern- und Lehrmaterialien

- Offenheit von Lehr- und Forschungsressourcen: nur ein Trend oder ein neues Paradigma?

- Literatur

- Lernen mit Videokonferenzen

- Entwicklung von Videokonferenzen

- Szenarien des Lernens in Videokonferenzen

- Kommunikation in Videokonferenzen

- Unterstützung des Lernens in Videokonferenzen

- Anwendung von Videokonferenzen

- Fazit

- Literatur

- Simulationen und simulierte Welten

- Einführung

- Grundlage des Lernens mit Simulationen und simulierten Welten

- Der Einsatz von Simulationen und simulierten Welten als Lernumgebung

- Zentrale Erkenntnisse

- Literatur

- Die Akteur-Netzwerk-Theorie

- Einleitung

- Techniktheorien in Bildungsprozessen

- Die Akteur-Netzwerk-Theorie

- Die Akteur-Netzwerk-Theorie am Beispiel von Netbooks im Unterricht

- Literatur

- Barrierefreiheit

- Grundsätzliches Verständnis von Barrierefreiheit: „equality = e-quality“

- Zahl der Menschen mit Behinderung

- Arten der Behinderung und spezielle Bedürfnisse hinsichtlich Barrierefreiheit

- Gesetzliche Rahmenbedingungen und Richtlinien / Standards zur Umsetzung

- Grundlegende Anforderungen – Zugangsrichtlinien

- Zentrale Problematiken hinsichtlich webgestützten Lehrens und Lernens

- Werkzeuge und Methoden zur Überprüfung und Optimierung

- Ausblick

- Literatur

- Genderforschung

- Konzept von „Gender“ und Genderforschung

- Ansätze und exemplarische Fragestellungen der Genderforschung im Kontext des Lernen und Lehrens mit Technologien

- Gender und (neue) Technologie

- Literatur

- Zukunftsforschung

- Einleitung

- Von Buzzwords und Innovationen

- Theorien zur Einführung von Technologien

- Zukunftsforschung

- Güte und Kritik der Zukunftsforschung

- Ansätze der Innovationsentwicklung

- Zusammenfassung und Ausblick

- Literatur

- Kognitionswissenschaft

- Einleitung

- Das Entstehen eines neuen Forschungsfeldes

- Klassische Kognitionswissenschaft

- Konsequenzen für Lernen und Lehren mit Technologien: Die Frage des adäquaten Wissensbegriffs

- Der Übergang zu einer neuen Sicht auf Kognition: Der Konnektionismus und die Simulation neuronaler Prozesse

- Embodied and Situated Cognition, Enactivism

- Konsequenzen für unsere Sicht auf Wissen, Lernen und Technologien

- Literatur

- Diversität und Spaltung

- Lern-Service-Engineering

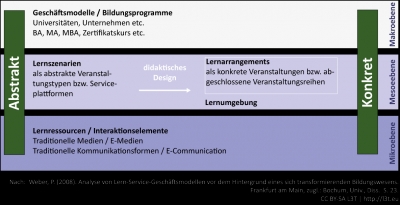

- Hintergrund eines betriebswirtschaftlichen Service-Verständnisses von technikgestütztem Lernen

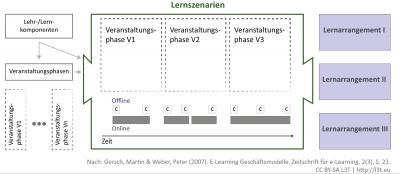

- Systematisierungsansatz für technikgestützte Lehr-/Lernkomponenten

- Lern-Service-Engineering: Ansätze zur Unterstützung einer systematischen Entwicklung von Lern-Services

- Ein neues Rollenverständnis von Lehrenden

- Fazit

- Literatur

- Medientheorien

- Metaphern, Medien und Dekonstruktion: „There is nothing outside the text“

- Neue Medien zwischen Gefahr und Chance: Romane als Opiumrauch

- Das Neue an den Neuen Medien

- Medientheorien und die Gestaltung neuer Medien

- Zusammenfassung

- Literatur

- Das Gesammelte interpretieren

- Datenanalysen sind so alt wie der Computer selbst

- Educational Dataminig (EDM)

- Learning Analytics (LA)

- EDM und LA im Spannungsfeld des Datenschutzes

- Wirkung von EDM und LA auf Unterrichtsgestaltung

- Literatur

- Wissensmanagement

- Grundlagen des Wissensmanagements

- Modelle und Trends

- Informelles Lernen im betrieblichen Kontext

- Mensch und Ökonomie

- Fazit

- Literatur

- Sieht gut aus

- Einleitung

- Grundlagen der visuellen Wahrnehmung

- Visuelle Gestaltung in der Praxis

- Limitierung, Konklusion

- Literatur

- Urheberrecht & Co. in der Hochschullehre

- Digitale Lehre im Visier

- Urheberrecht

- Erlaubte Nutzung von urheberrechtlich geschützten Werken

- Datenschutz

- Literatur

- Interessen und Kompetenzen fördern

- Einleitung

- Lernmöglichkeiten und Bildungspotenziale

- Hinweise zur Gestaltung von Angeboten

- Beispiele für Bildungsangebote

- Fazit

- Literatur

- Spielend Lernen im Kindergarten

- Kinder und ihr Zugang zu neuen Technologien

- Einsatz von neuen Technologien zur Medienbildung

- Aktiv, kreativ und kooperativ mit Medien umgehen

- Lernmethodische Kompetenz stärken

- Spiel als wichtigste Lernform

- Faktoren die den Umgang mit Technologien im Kindergarten beeinflussen

- Literatur

- Technologieeinsatz in der Schule

- Rahmenbedingungen: Medieneinsatz an Schulen

- Einsatz von Technologien – didaktische Möglichkeiten

- Weitere Aspekte der Medienbildung in der Schule

- Zusammenfassung

- Literatur

- Technologie in der Hochschullehre

- Einleitung

- Rahmenbedingungen

- Herausforderung: Präsenz-Massenlehrveranstaltungen

- Didaktische Modelle

- Literatur

- Fernstudium an Hochschulen

- Einleitung

- IT-Infrastruktur im heutigen Fernstudium

- Hochschullehre im Wandel

- Exemplarische Lehrkonzepte von Fernuniversitäten

- Literatur

- Webbasiertes Lernen in Unternehmen

- Hintergrund

- Die Gründe des Technologieeinsatzes

- Die Entscheider/innen

- Die Zielgruppen

- Die Lernformen und Themengebiete

- Drei Entwicklungsstufen des computer- und netzgestützten Lernens in Unternehmen

- Kriterien für den Einsatz von Technologien und Lernformen

- Die Erfolgsfaktoren

- Ausblick

- Literatur

- E-Learning in Organisationen

- Ausgangspunkt: E-Learning als Bildungsinnovation einführen

- Strategische Einführung: E-Learning als Bildungsinnovation nachhaltig integrieren

- Entwicklung innovativer Maßnahmen zur Kompetenzentwicklung: Integration und Gestaltung von E-Learning als Bildungsinnovation

- Gestaltung lern- und innovationsförderlicher Rahmenbedingungen: E-Learning nachhaltig implementieren

- Literatur

- Erwachsenen- und Weiterbildung

- Begriffserklärung

- Technologieunterstütztes Lernen bei Erwachsenen

- Technologie- und Medieneinsatz in der Erwachsenen- und Weiterbildung

- Literatur

- Freie Online-Angebote für Selbstlernende

- Einleitung

- Frei verfügbare, kursungebundene Lernressourcen

- Offene Online-Kurse

- Notwendige Kompetenzen zum Selbstlernen mit freien Online-Angeboten und Anreizsysteme

- Perspektivisches Fazit

- Literatur

- Sozialarbeit

- Human- und Tiermedizin

- Einleitung

- Formales Lernen

- Lerntechnologieeinsatz

- Netzwerke und curriculare Integration

- Didaktik

- Lebenslanges Lernen

- Wissensmanagement / Informelles Lernen

- Elektronische Prüfungen

- Qualitätssicherung

- Literatur

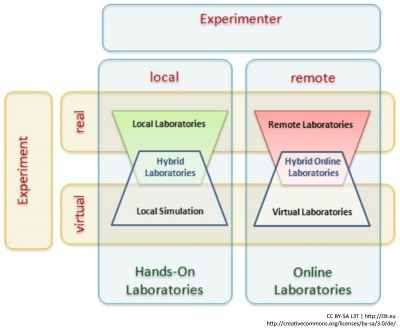

- Online-Labore

- Einführung

- Was sind Online-Labore?

- Stand der Technik

- Online-Labore in der Lehre

- Gute Online-Labore

- Förderorganisationen

- Entwicklungstrends

- Zusammenfassung

- Literatur

- Mehr als eine Rechenmaschine

- Bildungstechnologien im Sport

- Einleitung: Gegenstand ‚Sport‘ und die ambivalente Stellung von Bildungstechnologien

- Forschungsstand

- Einsatzmöglichkeiten und Praxisbeispiele: Selbstreflexion, Wissensproduktion und Kollaboration mit digitalen Medien

- Forschungsdefizite und Entwicklungsperspektiven

- Literatur

- Fremdsprachen im Schulunterricht

Einleitung

L3T ist überarbeitet und steht nun in der zweiten Auflage zur Verfügung. Wie es dazu kam und wie es im Rahmen des Projekts „L3T 2.0“ umgesetzt wurde, ist hier festgehalten. Da sich die Entstehung dieses Lehrbuchs deutlich von anderen Buchprojekten unterscheidet, wollen wir auch Einblick in den Entstehungsprozess geben. Ebenso, quasi als Vorwort in eigener Sache, wird beschrieben, worum es im Lehrbuch geht und wie man damit umgehen soll. So hat jedes Kapitel ein eigenes Schlagwort, einen Hashtag (#), auf den sich einerseits die Kapitel untereinander beziehen und mit denen andererseits im World Wide Web weitere Materialien bei verschiedenen Serviceangeboten zugänglich sind. Schließlich sprechen wir in dieser Einleitung noch jede Menge Danksagungen aus, denn das Buch ist nicht das Werk von wenigen Personen, sondern ein Projekt, bei dem immerhin rund 250 Personen mit- und zusammengewirkt haben!

L3T – die zweite Auflage

In der Einleitung zur ersten Auflage von L3T, die am 1. Februar 2011 auf der Learntec online ging, kann man zu den Absichten, L3T in einer neuen Auflage zu veröffentlichen, nachlesen: „Bis dahin gibt es jedoch allerhand zu tun, und zum Zeitpunkt der Veröffentlichung dieser Einleitung wissen wir selbst noch nicht im Detail, was alles im Bezug auf L3T passieren wird. Vor einem Jahr hatten wir die Idee, ein Lehrbuch zu initiieren ja noch nicht einmal ausgesprochen – wie sollen wir jetzt wissen, was in den nächsten drei Jahren passiert!“.

Die Zeit ist wie im Flug vergegangen und L3T ist wohl zu einem der bekanntesten deutschsprachigen Lehrbücher am Sektor des technologiegestützten Lernens und Lehrens aufgestiegen. Unglaubliche 235.000 Downloads der Kapitel (http://l3t.tugraz.at/analytics/, Stand 6.8.2013) zeugen von einer hohen Resonanz des Projekts und geben somit auch dem Ansatz des freien Zugangs Recht. Zahlreiche Pressemeldungen, Preise und Auszeichnungen haben uns nachhaltig bestärkt den richtigen Weg eingeschlagen zu haben. L3T ist von einem simplen Buch zu einer E-Learning-Marke aufgestiegen, die vor allem eines war und ist: ein Community-Projekt, in dem alle eingeladen sind, mitzumachen und beizusteuern bzw. umgekehrt auch davon für die eigenen Arbeiten, Weiterbildungen oder sonstigen Tätigkeitenzu profitieren.

Wie erwähnt, hatten wir als Herausgeber immer eine Überarbeitung im Auge, da unser Fachbereich natürlich einen großen Vorteil hat, der sich bei näherer Hinsicht jedoch auch manchmal als Nachteil entpuppt: Was heute noch als innovativ gilt, wird morgen bereits von der nächsten Technologie überholt. Nun entspricht es unserer persönlichen Auffassung von Wissenschaft und unserem Projektverständnis, dass eine Überarbeitung von L3T auch hier etwas bieten sollte, das neu und anders ist und auch der Wissenschaft unseres Fachbereichs weiterhilft.

Tja, wenn man nicht weiß, wie man etwas angehen soll, dann hilft oft eines: ein Spaziergang, bei dem man lacht und herumalbert. Auf die Frage von Sandra: „Wie stellst du dir eigentlich die zweite Version von L3T vor?“, gab Martin die Antwort: „Ach, ich will, dass nach einer Woche Rauch aufsteigt und ich aus dem Haus komme und das Buch fertig ist“.

Und schon war die Idee für L3T 2.0 geboren. Klar ein schräger Gedanke, ein Buch auf diese Weise, innerhalb eines so geringen Zeitrahmens fertigzustellen, aber er ließ sich nicht mehr aus unseren Köpfen verbannen. (Es könnte sein, dass es sich auch ein bisschen anders zugetragen hat. Weil wir uns nicht mehr genau daran erinnern, wie es war, steht im Weblog zum Projekt eine etwas andere Variante.)

Jedenfalls konkretisierte sich dazu eine gezielte Fragestellung, die wir im Folgenden mit verschiedenen Personen diskutiert haben: „Ist Echtzeit-Zusammenarbeiten in jener Form möglich, sodass ein solches Buch in einer Woche umsetzbar ist?“ Insbesondere ist da Joachim Wedekind zu erwähnen, der mit Martin bei der Veranstaltung L3T’s WORK im Juni 2012 schon sehr konkret an der Idee arbeitete. Die folgende Resonanz bei einer Kurzvorstellung, war wohl dann der letzte Kick, der uns das Projekt für die Ausschreibung „netidee“ einreichen ließ, da dieses Mal klar war: Gänzlich ohne finanzielle Mittel ist so etwas nicht umsetzbar.

Die Antwort war positiv: das Projekt wurde genehmigt und eine Reihe von Ausgaben, beispielsweise für Marketing-Materialien waren nun gedeckt. Leider jedoch nur ein sehr kleiner Teil unserer Arbeitszeit, doch nun hieß es: Jetzt gibt es kein Entkommen mehr, es gilt diese Idee umsetzen und ein schräges, eigentümliches Projekt vom 20. bis zum 28. August 2013 durchzuführen.

Nun aber alles der Reihe nach. Dieses Einleitungskapitel erklärt generell was L3T ist, wem es helfen soll und unter welcher Lizenz die Inhalte stehen. Auch wird die eigentliche Umsetzung beschrieben und zuletzt eines ausgesprochen: DANKE. Ein großes Danke an euch, die mitgeholfen, die genauso wie wir an diese verrückte Idee geglaubt und einen Baustein dazu beigetragen haben, um das große Ganze zu erreichen.

Was ist denn eigentlich „L3T“?

Weil das „Lehrbuch für Lernen und Lehren mit Technologien“ ein langer und vor allem sperriger Titel ist, haben wir ihn schlicht und einfach zu „L3T“ (also dreimal L und einmal T) abgekürzt. Wir bezeichnen so gleichermaßen das Lehrbuch an sich wie auch das gesamte Projekt. Auch die englische Übersetzung „Textbook for Learning and Teaching with Technologies“ liefert übrigens das gleiche Akronym (dreimal T und einmal L). Wir sprechen es „EL-DREI-TE“ aus, aber greifen insbesondere bei Marketingmaßnahmen gerne auf Leetspeak zurück, wo die „3“ zu einem „E“ wird. So haben wir beispielsweise diverse Slogans wie „L3T’s WORK“ oder „L3T’s do it“ verwendet.

Zielgruppe und Themenfeld

Ein Lehrbuch richtet sich an Lernende, die sich ein Forschungs- und Praxisgebiet erschließen möchten und an Lehrende in Studiengängen im jeweiligen Themenfeld, die Anregungen und Unterlagen für ihren Unterricht suchen. Das Themenfeld „Lernen und Lehren mit Technologien“ ist dabei weit gefasst: Es beinhaltet alle Lern- und Lehrprozesse sowie -handlungen, bei denen technische, vor allem elektronische (zumeist auch digitale) Geräte und/oder dafür erstellte Anwendungen eingesetzt werden. Ein besonderes aber nicht ausschließliches Augenmerk liegt dabei auf Anwendungen und Geräten der Informations- und Kommunikationstechnologien (IKT). Dieses Lehrbuch für Lernen und Lehren mit Technologienwendet sich also an Studierende und Lehrende in einem interdisziplinären Themenfeld, das Aspekte von Pädagogik, Informatik, Psychologie und zahlreichen anderen angrenzenden Wissenschaftsgebieten berührt.

Inhalt im Überblick

In 59 Kapiteln werden unterschiedliche Facetten und Gesichtspunkte des Fachbereichs ausgewählt. Der Bogen ist dabei weit gespannt: von eher historischen Beiträgen, welche die Entwicklung des „Hypertext“ oder des Fernunterrichts beschreiben, über eine Reihe von Beiträgen, die einzelne Theorien und Forschungsansätze aufgreifen, bis zu Beschreibungen des Einsatzes von Technologien in ausgewählten Bildungssektoren und Fachgebieten. Viele davon behandeln Themen, die derzeit in den (akademischen) Aus- und Weiterbildungsprogrammen behandelt werden. Es gibt aber auch eine Reihe von Beiträgen, die nicht zum eigentlichen Kerncurriculum des Fachbereichs gehören, aber deutlich machen, wie vielfältig und unterschiedlich der Einsatz von Technologien behandelt wird. Ein gutes Beispiel dafür sind die Beiträge zum Technologieeinsatz im Sport oder der Tiermedizin. Einige Kapitel sind für Studierende, die Informatik oder Pädagogik studieren, weniger interessant, da sie ihnen bereits bekannte Inhalte beschreiben werden. Umgekehrt, und auch für all diejenigen, die keine Vorkenntnisse in der Informatik und Pädagogik haben, sollten diese einführenden Kapitel aber hilfreiche Unterstützung bieten.

Viele der Themen, die im Lehrbuch behandelt werden, finden sich in Abbildung 1, der L3T-Landkarte, wieder: Visualisiert als Städte, Gebirge, Seen, Inseln usw. kann man hier die Gegenden (Themengebiete) des Lehrbuchs erkunden.

!

Das Lehrbuch für Lernen und Lehren mit Technologien ist auf der Homepage http://l3t.eu zugänglich. Dort findet man viele weitere Materialien und Interaktionsangebote, die es erlauben, zu diskutieren oder weitere Inhalte zu erlangen.

Zugänge zum Lehrbuch

Das Lehrbuch und seine Kapitel erscheinen in unterschiedlichen Formen. Zunächst einmal gibt es alle Kapitel mit freiem Zugang am Webportal von L3T: http://l3t.eu. Um das Einbinden der Kapitel beispielsweise in Weblogs zu ermöglichen, gibt es alle Kapitel auch im L3T-Slideshare-Account (http://www.slideshare.net/L3Tslide).

Alle Kapitel sind mit einer Creative-Commons-Lizenz versehen, die es erlaubt, die Beiträge im Unterricht zu nutzen, sie zu versenden oder sie auch auf anderen Plattformen zur Verfügung zu stellen. Eine wesentliche Neuerung zur ersten Version ist, dass in der Auflage zwei die Inhalte so verfügbar sind, dass sie auch ohne Bedenken in Auszügen in eigenen Präsentationen bzw. auch in der kommerziellen Weiterbildungverwendet werden können. Schon in den sieben Tagen der Erstellung der Neuauflage wurden so Kapitel auf anderen Plattformen aufbereitet, zum Beispiel auf der Loop-Plattform (http://l3t.oncampus.de/) bzw. die Archivierung vorbereitet, zum Beispiel auf Pedocs (http://www.pedocs.de/). Wer sicher gehen will, eine aktuelle, originale Version eines Kapitels zu haben, sollte jedoch immer direkt auf die L3T-Website zugreifen. Den genauen Text der Lizenz kann man im Internet nachlesen beziehungsweise bei Unsicherheit oder zu weiteren Absprachen die L3T-FAQ zu Rate ziehen (siehe http://creativecommons.org/licenses/by-sa/3.0/de/).

Für Nutzerinnen und Nutzer eines iPhones oder Android-Mobiltelefons gibt es jeweils eine App, die das komfortable Lesen der Kapitel auf den entsprechenden mobilen Endgeräten möglich macht. Auch eine iPad-App steht zur Verfügung.

!

Sie können jederzeit mit den Herausgebern des Buches in Kontakt treten, entweder unter martin.ebner@l3t.eu oder sandra.schoen@l3t.eu.

!

Die Apps im Überblick:

Ergänzend gibt es L3T auch wieder als gedrucktes Buch. Das Buch ist als Service für alle gedacht, die gerne blätternd schmöken, mit dem Stift markieren, bei gleißendem Sonnenschein lesen möchten oder wenn ausnahmsweise kein digitales Endgerät vorhanden ist.

Gliederung des Lehrbuchs

Es ist nicht simpel, 59 Kapitel in eine Reihenfolge zu bringen, die für alle Leserinnen und Leser mit unterschiedlichen Voraussetzungen die richtige ist. Es ist wohl auch nicht möglich. Die Kapitel wurden zunächst drei Hauptgruppen zugeteilt: Beiträge, die als Einstiegstexte Übersichten geben, welche für viele weitere Kapitel Voraussetzungen sind, wurden dem Abschnitt „Einführung“ zugeordnet. Dann gibt es eine Reihe von Beiträgen, von denen wir annehmen, dass sie derzeit zum Kerncurriculum gehören, da sie Themen ansprechen, die in den Basismodulen aktueller Fortbildungsangebote genannt werden. Diese Beiträge finden sich im Abschnitt „Vertiefung“. Schließlich gibt es noch – auch in großer Zahl – Kapitel, die über das (aktuelle) Kerncurriculum hinausgehen. Diese wurden schließlich dem Abschnitt „Spezial“ zugeordnet. Dabei handelt es sich um Beiträge, die den Einsatz von Technologien zum Lernen und Lehren in bestimmten Bildungssektoren oder zu Fachgegenständen („Schulfächern“) beschreiben. Zu diesem Bereich gehören aber auch Beiträge, die den Einsatz von Werkzeugen und Methoden oder einzelne theoretische Zugänge und Forschungsansätze beschreiben. Es kann übrigens durchaus sein, dass die Beiträge in diesem Sektor für das eigene Studium oder Lehrgebiet zentral sind!

In der Online-Version des Lehrbuchs und auf der ersten Seite der Kapitel gibt es jeweils eine Reihe von weiteren Schlagworten, mit denen die Kapitel versehen wurden. Diese Schlagworte sind kleingeschrieben und beginnen mit einem Doppelkreuz, dem sogenannten „Hash“ (engl. „hashtag“). Das erste Schlagwort ist eine eindeutige Bezeichnung für dieses Kapitel, unter der es adressierbar und damit referenzierbar ist. Die weiteren Schlagwörter wurden mehrfach vergeben, so dass sich mit ihrer Hilfe die Kapitel auf weitere Arten auswählen und gruppieren lassen. Man kann dadurch zum Beispiel schnell einen Überblick über Inhalte bekommen, die zum Beispieleher Theorien und Forschung thematisieren (versehen mit #theorieforschung).

!

Das Lehrbuch verwendet zur Referenzierung der einzelnen Kapitel Hashtags (#). Damit können Verweise ohne eine weitere Nummerierung gesetzt beziehungsweise auch Verknüpfungen mit Online-Diensten hergestellt werden (durch die Eingabe der entsprechenden Tags).

Gestaltung der Kapitel

Allen Kapiteln ist gemein, dass sie neben einer Zusammenfassung, einer kurzen Einleitung sowie einem kurzen Fazit in das Themenfeld einführen und einen Überblick geben. Die Autorinnen und Autoren wurden dabei gebeten, wichtige Aussagen oder Bemerkenswertes zu kennzeichnen; solche Aussagen wurden in Kästchen gesetzt (Kennzeichnung: Rufzeichen). Ebenso erhalten alle Kapitel eine Reihe von Aufgaben unterschiedlicher Natur, die ebenso markiert wurden (Kennzeichnung: Fragezeichen). Neben Reflexions- und Wiederholungsfragen für einzelne Lernende und Leser/innen sind dies auch oft Aufgaben, die im Rahmen von Seminaren in kleinen Gruppen bearbeitet werden können.

Fast alle Kapitel haben abschließend auch eine oder mehrere graue Kästen, die mit „### In der Praxis“ überschrieben werden. Hier wird versucht, die konkrete Praxis zu beschreiben und Einblick in die tägliche Arbeit zu geben. In Forschungskapiteln kann dies auch als „Forschungspraxis“ zur Beschreibung von einzelnen Untersuchungen und Experimenten ausgewiesen sein.

Weitere Materialien zu den Kapiteln

Das erste Schlagwort im grauen Kasten auf der ersten Seite (bei dieser Einleitung ist es zum Beispiel #einleitung) ermöglicht es, diesem Kapitel auch noch weitere Materialien zuzuordnen, die im Internet zu finden sind. Wir nutzen dabei insbesondere, aber nicht ausschließlich, den Social-Tagging-Service Diigo (https://groups.diigo.com/group/l3t_20). Mit den entsprechenden Schlagworten lassen sich hier Internetadressen zu Videos und weiteren Informationen zu den Artikeln finden, wie etwa Anwendungsbeispiele oder auch Vertiefungsliteratur (sofern sie frei im Web zugänglich ist).

!

Die Hyperlinks zum Kapitel sind unter https://groups.diigo.com/group/l3t_20 auffindbar, welche von Heiko Idensen hier gesammelt wurden.

L3T 2.0 – Organisation, Ablauf und Neues

L3T ist kein klassisches Lehrbuch. Schon die erste Version zeichnete sich dadurch aus, dass es ein Gesamtwerk von rund 200 Personen war, die ein Ziel hatten – ein Lehrbuch für den Fachbereich frei zugänglich zu machen.

Die Erarbeitung einer erweiterten, vollständig überarbeiteten Version von L3T im Rahmen des Projekt „L3T 2.0“ sollte das natürlich beibehalten, Schwächen der ersten Version ausmerzen und sowohl technisch als auch organisatorisch einen Schritt weitergehen.

Organisatorisch lag die wesentliche Herausforderung darin, die wesentliche Arbeit in nur sieben Tagen zu erledigen, dazu detaillierte Planungen und Organisationen vorzubereiten, die richtigen Werkzeuge auszuwählen und auch genügend Mitmacher/innen zu finden.

Gleichzeitig galt es auch, die Autorinnen und Autoren davon zu überzeugen, wieder dabei zu sein und die Texte diesesmal noch offener, nämlich unter der Creative-Commons-Lizenz CC BY-SA zur Verfügung zu stellen, welche auch Modifizierungen der Texte erlaubt.

Da bei der ersten Auflage kritisiert wurde, dass nur ein PDF-Version erhältlich ist, soll die neue Auflage möglichst auch als XHTML sowie EPUB-Datei zur Verfügung gestellt werden. Hier erschien es uns unmöglich, in sieben Tagen mehrere Versionen nacheinander zu erstellen oder Korrekturen in drei Dateien parallel vorzunehmen. So entstand die Idee des L3T-E-Book-Editors, der die entsprechenden Datei-Formate, soweit dies möglich ist, layoutiert und „schön“ gestaltet, aber nur auf einer Basisdatei beruht.

Seit wir die Idee des Booksprints im Januar 2013 offiziell allen unter http://l3t.eu/2.0 (unserem Weblog zum Projekt) zugänglich machten, gab es vieles zu erledigen. Begonnen haben wir bei den Autorinnen und Autoren der ersten Version mit der Anfrage, ob sie die Überarbeitung ihres Kapitels durchführen wollen. Weiters wurden neue Kapitel definiert und aktive potentielle Autorinnen und Autoren gesucht. Es gab eine circa sechswöchige Online-Phase, in der wir Rückmeldungen zu den bestehenden Kapiteln mittels Etherpads sammelten. Parallel dazu wurden acht Standorte für Camps über ganz D-A-CH ausgewählt. Im ersten Online-Meeting der Campleiterinnen und -leiter im Mai 2013 wurden so die ersten Pläne durchgegangen und über Marketingmaßnahmen gesprochen, um möglichst viele Personen involvieren zu können. Danach war der Stein im Rollen, Jobs wurden auf der Webseite definiert und die Social-Media-Kanäle mit Informationen bespielt.

Neben dem eigentlichen Schreiben kamen auch auf den ersten Blick verrückte Ideen auf, wie zum Beispiel jene der mobilen Reporterin, die alle Camps während der Woche besuchen sollte, oder der täglichen Live-Sendung „L3T TV“. Anfang Juli, also rund sechs Wochen vor den eigentlichen sieben Tagen, waren wir drei Projektorganisatoren nur noch mit L3T 2.0 beschäftigt: Der E-Mail-Austausch stieg an, viele Autorinnen und Autoren luden ihre überarbeiteten Beiträge hoch (einige planten in „unseren“ sieben Tagen Urlaub.

Die Umsetzung eines solchen Buches in einer Woche erfordert natürlich eine gute Organisation und auch hohe Disziplin aller Beteiligten. Sämtliche Prozesse müssen transparent und offen gestaltet sein, um Missverständnisse zu vermeiden und die Kommunikation so gut es geht zu ermöglichen und dabei überquellende E-Mail-Eingangsordner zu vermeiden. Außerdem soll auch jede/r sehen, welchen Beitrag sie/er leistet, wo das eigene Kapitel gerade steht und wo das gesamte Projekt gerade steht. In der Vorbereitung wurden dann neben den Campleiter/innen auch Verantwortliche für die einzelnen Bereiche (Autorinnen und Autoren, Gutacher/innen, Lektor/innen usw.) definiert, die mit Hilfe von öffentlich einsehbaren Boards in der Webapplikation Trello die Übersicht in der Woche wahren sollten. Einschulungen für Layouter/innen, Besprechungen mit Literaturverantwortlichen, dem Juristen, den Layouter/innen, den Verantwortlichen für die Bilder, Lektor/innen usw. komplettierten die umfangreichen Organisationsaufgaben.

Dann ging es tatsächlich los. Pünktlich starteten wir mit L3T TV am 20.8.2013 um 09.00 Uhr und führten in die Projektwoche ein. Die tägliche Morgensendung sollte uns dann die ganze Woche begleiten und uns umfassend über verschiedenste Tätigkeiten in den Camps informieren. Im Anschluss wurde der Livestream zwischen den Camps geöffnet (hier gilt ein besonderer Dank der Firma Visocon), um einen ständigen Austausch zu gewährleisten, und auf den Trello-Boards wurden die Aufgaben den einzelnen Personen zugeteilt. Mit hoher Konzentration wurde dann den ganzen Tag gearbeitet – geschrieben, gelesen, lektoriert, ausgebessert, überprüft, layoutiert, versendet. Tägliche Redaktionssitzungen halfen, die Übersicht über das Projekt zu bewahren.

Trotzdem haben die einzelnen Camps auch für Abwechslung gesorgt, etwa durch Besuche von Journalistinnen und Journalisten, Autorinnen und Autoren oder insbesondere auch durch geplante Aktionen, wie die „schräge Stunde“, eine Stunde geplanter „Auszeit“ während der sieben Tage. In dieser hatten die Camps die Aufgabe einmal etwas ganz anderes zu machen. Vieles ist davon im Weblog dokumentiert und kann dort gerne nachgelesen und angeschaut werden.

Um alle Beteiligten und Interessierten auf dem Laufenden zu halten, um die Aktivitäten zu koordinieren sowie, um auch potentielle Leser/innen zu gewinnen, wurden natürlich auch sämtliche Social-Media-Kanäle genutzt. Entweder konnte man in Twitter unter dem Hashtag #l3t mitlesen oder auf Facebook bzw. Google+ kommentieren.

!

Die Social-Media-Aktivitäten von L3T im Überblick:

- Facebook: http://facebook.com/l3t.eu

- Twitter: Verwendung des Hashtags #l3t

- Google+: Page L3T

- Diigo: https://groups.diigo.com/group/l3t_20

- Flickr-Gruppe: http://www.flickr.com/photos/99566143@N05

- Slideshare: http://www.slideshare.net/L3Tslide

In Kenntnis pädagogischer Prinzipien, nämlich, dass man gemeinsames Lernen und Arbeiten auch feiern muss, haben wir am Ende der Projektwoche nach der Pressekonferenz natürlich auch in allen Camps angestoßen.

Projektpartner/innen und Unterstützer/innen

Ein solches Projekt kann selbstverständlich nur funktionieren wenn es unterstützt wird und deswegen dürfen wir hier alle Projektpartner/innen anführen:

Salzburg Research Forschungsgesellschaft [Projektleitung], Technische Universität Graz [Projektleitung, Camp], Multimedia Kontor Hamburg [Camp], FH Köln [Camp], httc e.V. [Camp], Freie Universität Berlin | Professur Gersch [Camp], Technische Universität Chemnitz [Camp], e-teaching.org | Leibniz-Institut für Wissensmedien (IWM) [Camp], Universität der Bundeswehr München [Camp], Internet Austria Foundation im Rahmen der Initiative Netidee [Ko-Finanzierung], Österreichische UNESCO Kommission [Schirmherrschaft], evolaris [Unterstützung mobile Reporterin], Tiroler Bildungsservice [Unterstützung Fotos], Visocon [Unterstützung Camp Graz, Livestreaming]

Danke, danke, danke!

´Natürlich muss so ein Projekt, das im Verlauf ständig wuchs und größere Ausmaße als geplant annahm, von zahlreichen Mitstreiterinnen und Mitstreitern mitgetragen und unterstützt werden. Wir möchten versuchen alle Beteiligten namentlich zu nennen und entschuldigen uns bei allen, die wir dann doch im Eifer des Gefechts übersehen haben. Es ist schwierig, bei ungefähr 250 Mitwirkenden den Überblick zu behalten (siehe Box „Dankeschön!“).

Aber nachdem wir alles updaten können, bitten wir im Falle eines Versehens, dies umgehend mitzuteilen, wir fügen euch gerne hinzu.

In der Praxis: Dankeschön!

Autorinnen und Autoren:

Viele alte bekannte aber viele neue Autorinnen und Autoren konnten wir auch für die zweite Ausgabe gewinnen (in alphabetischer Reihenfolge): Ralf Appelt, Patricia Arnold, Michael E. Auer, Andreas Auwärter, Peter Babnik, Gabriele Bäuml-Westebbe, Andrea Belliger, Yves Bochud, Christian Böhler, Taiga Brahm, Klaus Bredl, Gerlinde Buchberger, Ilona Buchem, Johanna Chardaloupa, Christoph Derndorfer, Johannes Dorfinger, Martin Ebner, Marc Egloffstein, Jan Ehlers, Ulf-Daniel Ehlers, Andreas Eitel, Nicole Engelhardt, Bernhard Ertl, Jessica Euler, Corinna Fink, Christian F. Freisleben-Teutscher, Jennifer Frey, Roland Gabriel, Marc Garbely, Claudia Gartler, Martin Gersch, Susanne Gruttmann, Christian Gütl, Jan Hansen, Andreas Hebbel-Seeger, Andreas Hediger, Kathrin Helling, Jacqueline Henning, Erich Herber, Ilona Herbst, Klaus Himpsl-Gutermann, Andreas Holzinger, Susan Höntzsch, Heiko Idensen, Friedrich Ittner, Tanja Jadin, Tobias Jenert, Verena Heckmann, Sascha Kaiser, Frank Kappe, Stefan Karlhuber, Uwe Katzky, Tine Knieriemen, Tanja Kohn, Michael Kopp, Dirk Krause, Brigitte Kreplin, Rolf Kretschmann, David Krieger, Clemens Kroell, Mark Krüger, Elke Lackner, Volkmar Langer, Son Le, Christian Lehr, Andre Lenich, Conrad Lienhardt, Markus Linten, Clemens Löcker, Anja Lorenz, Mark Markus, Hermann Maurer, Christoph Meier, Klaus Meschede, Johannes Metscher, Günter Mey, Klaus Miesenberger, Katja Mruck, Walther Nagler, Manuela Pächter, Stefanie Panke, Denise Paschen, Georgios Perperidis, Markus F. Peschl, Andreas Pester, Margit Pohl, Robert Pucher, Peter Purgathofer, Gergely Rakoczi, Klaus Reich, Gabi Reinmann, Christoph Rensing, Jochen Robes, Brigitte Römmer-Nossek, Guido Rößling, Hannes Rothe, Christian Safran, Werner Sauter, Steffen Schaal, Elisabeth Schallhart, Elisabeth Schaper, Mandy Schiefner-Rohs, Bernhard Schmidt-Hertha, Martin Schön, Sandra Schön, Rolf Schulmeister, Heike Seehagen-Marx, Sabine Seufert, Kai Sostmann, Christian Spannagel, Marcus Specht, Kerstin Stöcklmayr, Maria Süß, Behnam Taraghi, Michael Tesar, Anne Thillosen, Christoph Trappe, Claus A. Usener, Timo van Treeck, Thomás Vogel, Frank Vohle, Stephan Waba, Günter Wageneder, Peter Weber, Ulrich Weber, Kirstin Wessendorf, Marc Widmer, Diana Wieden-Bischof, Andreas Wittke, Sabine Zauchner-Studnicka, Olaf Zawacki-Richter, Elisabeth Zimmermann und Isabel Zorn.

Gutachterinnen und Gutachter:

Etliche Autorinnen und Autoren waren auch als eine/r der über 60 Gutachter/innen aktiv. Darüberhinaus waren im Einsatz: (soweit nicht Autor/in): Laura Ackermann, Tanja Adamus, Carina Aichinger, Judith Bündgens-Kosten, Aline Bergert, Gerhard Bisovsky, Ute Blumtritt, Guido Brombach, Margit Busch, Marlen Dubrau, Romana Farthofer, Helge Fischer, Alexander Florian, Rüdiger Fries, Mario Ganz, Birgit Grieg, Leo Hamminger, Sandra Hofhues, Lothar Jurk, Rene Kaiser, Susanne Kannenberg, Alexander Kirchhof, Ralf Kretzschmar, Timo Lüke, Monika Lehner, Andrea Lißner, Knut Linke, Bernhard Maier, Claus Rainer Michalek, Johannes Moskaliuk, Michael Noll-Hussong, Sabine Oymanns, Cornelie Picht, Lisa Pomino, Annabell Preußler, Herwig Erich Rehatschek, Wolfgang Renninger, Sindy Riebeck, Christoph Scheb, Markus Schmidt, Jens Schulz, Daniel Sonderegger, Cathleen M. Stützer, Janina Sundermeier, Anne-Christin Tannhäuser, Ellen Trude, Joachim Wedekind, Olaf Zawacki-Richter und Anja Zeising.

Lektorinnen und Lektoren:

Für die sauberen, nun fast fehlerlosen Texte haben unermüdlich gearbeitet: Kristina Becker, Aline Bergert, Yvonne Bunk, Esther Debus-Gregor, Cornelia Graupner-Küsel, Margarete Grimus, Sandra Fink, Julia Finken, Christiane Geick, Gerhild Genzecker, Julia Glade, Birgit Grieg, Susanne Günther, Fabia Hartwagner, Elke Lackner, Nadine Kämper, Ulrike Kapp, Katharina Kiss, Michael Kopp, Klaus Meschede, Claudia Neumann, Kai Obermüller, Corinna Peters, Cornelie Picht, Elke Reher, Tanja Schnecker, Liesa Schönegger, Daniel Sonderegger, Annegret Stark, Janina Sundermeier, Oliver Tacke, Angelika Thielsch, Klaus Tscherne.

Illustrationen und Fotografien:

Es konnte auch kreativ an L3T mitgewirkt werden, viele haben speziell für L3T gezeichnet, fotografiert und illustriert. Darüber hinaus auch allen ein herzliches Dankeschön, die L3T Abdruckrechte erteilten oder ihre Materialien mit entsprechend freien Lizenzen zur Verfügung stellen. Unser Dank gilt einmal jenen, die die Illustrationen und Titelbilder anfertigten: Annine Amherd, Anetta Emmerich-Chrzonszcz, Tom Hänsel, Monika Hogrefe, Clemens Löcker, Susanne Molter, Benedikt Neuhold, Katharina Regulski, Hannes Rothe, Wey-Han Tan, Christine Warnke und Miriam Winkels.

Layouterinnen und Layouter:

Selbstverständlich muss ein Text auch in eine ansprechende Form gebracht werden mit der zusätzlichen Herausforderung dies auch für verschiedenste Endgeräte bereitzustellen. Dies ist nur gelungen durch die Arbeiten von: René Derler, Alexander Florian, Thomas Fössl, Gerald Geier, Anja Lorenz, Dörte Maasch, Walther Nagler, Benedikt Neuhold, Christoph Rensing, Markus Schmidt, Susanne Schumacher, Behnam Taraghi, Kai Obermüller, Walther Nagler, Michael Kopp und Michael Raunig.

Und dann sind da noch:

Viele Personen arbeiteten rund um das Projekt, indem sie die morgendliche TV-Sendung moderierten, sich um die Technik im Hintergrund bemühten oder von Camp zu Camp reisten. Hier sagen wir danke für eure speziellen Rollen, ihr wart maßgeblich daran beteiligt, dass die Camps mehr waren als Schreibwerkstätten: Carina Aichinger [International PR], Ute Blumtritt [L3T Archivierung], Martin Böckle [L3T Website - Visualisierungen], Daniel Brantner [Redakteur L3T TV], Michael Beurskens [Lizenz Hotline] Margit Busch [Hotline Zitation], Esther Debus-Gregor [Hotline Lektorat], René Derler [Programmierung Webeditor], Martin Ebner [Chef vom Dienst], Jennifer Frey [Organisation Lektorat], Nils Friedel [Koordination Blogger/innen], Anett Hübner [Evaluation], Heiko Idensen [Social Bookmarking], Peg Ködel [Community-Video], Sylvia Mössinger [International PR], Walther Nagler [Organisation AutorInnen], Clemens Löcker [Organisation Fotos]; Anja Lorenz [Organisation Review], Tina Pechmann [Moderation L3T TV], Yvonne Pöppelbaum [mobile Reporterin], Karin Reese [Literaturservice], Hannes Rothe [Organisation Illustrationen], Stephan Rupp [Literaturservice], Sandra Schön [Feelgood-Management], Alexander Schuc [Website L3T], André J. Spang [L3T Sound], Behnam Taraghi [Organisation Layout], Timo van Treeck [Organisation Checks], Jutta Wergen [Schreibcoach], Karl Wiesenhofer [Technik].

Weitere Danksagung:

Wer glaubt das war es nun, der irrt. Es gibt noch viele weitere Personen die aktiv L3T unterstützen und die es gilt zu erwähnen, teils waren sie rund um die Uhr aktiv: Andrea Brücken [PR Blogging], Christina Düll [Camp Köln], Julia Eder [PR], Susanne Eigner [PR], Michael En [Checks], Marika Fedtke [Checks], Ruth Frilling [Camp Köln], Daniela Gnad [Grafik], Christine Hoffmann [Social Bookmarking], Tracy Hoffmann [Camp Chemnitz], Ilka Kass [Checks], Alexander Koch [Fotos, Video Schräge Stunde Graz], Katja Lievertz [Camp Köln], Christoph Melnicki [Check], Klaus Meschke [Social Bookmarking], Iris Müller [Camp Tübingen], Alicia Neu [Camp Köln], Reinhard Poche [Camp Köln], Ingeborg Rose [Camp Köln], Barbara Rossegger [Checks], Alice Senarclens de Grancy [PR], Jana Scholz [Checks], Birgit Strohmeier [PR], Hedwig Seipel [PR Blogging], Cathrin Vogel [Checks], Anja C. Wagner [Social Bookmarking] und Marianne Wefelnberg [Checks].

Zu guter Letzt: Der enge Kreis:

Ein ganz besonderer Dank gilt den Campleiterinnen und Campleitern: Ohne ihre Bereitschaft unsere verrückte Idee umzusetzen und viele Stunden in der Vorbereitung und Durchführung zu investieren, wären wir zum Scheitern verurteilt gewesen: Bernhaldt Ertl und Alexander Florian (Universität der Bunderwehr München), Anne Thillosen (Leibniz-Institut für Wissensmedien (IWM) Tübingen, Jan Hansen und Christoph Rensing (httc e.V. in Darmstadt), Margarete Busch, Ulrike Glembotzky und Timo van Treeck (FH Köln), Hannes Rothe (FU Berlin), Anja Lorenz (TU Chemnitz) und Helga Bechmann (Multimedia Kontor Hamburg).

Nicht zu vergessen natürlich das Basiscamp an der TU Graz, wo wir drei vor Ort waren und uns gegenseitig den Dank aussprechen: Danke Jenny, danke Sandra und danke Martin! Wir haben es tatsächlich hinter uns gebracht und das, so hoffen wir, gar nicht so schlecht.

Und zu allerallerletzt gilt der Dank wie schon so oft auch unseren Kindern: Ihr habt unsere Begeisterung geteilt, uns in der Vorbereitung und Durchführung unterstützt, mit uns mitgefiebert, uns abgelenkt und uns auch in dieser stressigen Zeit daran erinnert, was neben aller Arbeit und Erfolge doch wirklich zählt. Wir haben Euch so sehr lieb!

Und so geht es weiter

Was soll man an dieser Stelle schreiben. Wir haben es nach der ersten Version nicht gewusst und wissen es genauso wenig bei der zweiten Version. Klar scheint uns, dass wir weiter an der Front der freien Bildungsressourcen kämpfen werden. Wir sind felsenfest davon überzeugt, dass dies ein wesentlicher und notwendiger Schritt in die richtige Richtung ist. Bildung muss frei zugänglich sein, denn das Ziel unserer und jeder Gesellschaft kann nur sein, die höchstmögliche Bildung dieser zu erreichen.

Natürlich muss es weitergehen, müssen auch die Kapitel verbessert, erneuert und einzelne Artikel ergänzt werden. Trotzdem sehen wir auch nach der zweiten L3T-Runde, dass hierzu nicht nur viel (private) Zeit notwendig ist, sondern, um es nachhaltig gestalten zu können, auch finanzielle Grundlagen geschaffen werden müssen.

In den folgenden Monaten werden wir weiter versuchen, durch Patenschaften für Kapitel der Online-Ausgabe entsprechende Einnahmen zu erwirtschaften, die für laufende Ausgaben und die mittelfristige Ko-Finanzierung zukünftiger Ausgaben notwendig sind. Hat es in der ersten Version noch nicht so gut geklappt, hoffen wir, dass wir in der Bewusstseinsbildung dieses Mal weiterkommen. Auch wenn Bildung frei zugänglich ist, müssen Strukturen geschaffen werden, diese aufrecht zu erhalten.

Wie eine dritte Version von L3T aussehen kann und auch wann es diese geben sollte, wollen wir uns noch offen halten. Aber wir gehen davon aus, dass, wenn wir uns von den Strapazen dieser Woche erholt haben und L3T 2.0 von der Community angenommen wird, neue Ideen sprießen und es zu jucken anfängt.

Ach ja: Nobody is perfect

… oder, auf Deutsch: Es ist noch keine Meisterin, kein Meister vom Himmel gefallen. Es ist nicht nur unser Lieblingsprojekt, sondern auch das bisher größte Projekt – was die Zahl der Mitwirkenden, nicht das Budget betrifft. Und das verrückteste, was die Zeitvorgabe von sieben Tagen belangt. Fehler bitten wir zu verzeihen und uns zu melden: Soweit das geht werden wir sie natürlich korrigieren – L3T steht nicht still. Nochmals, danke an alle Mitmacher/innen: L3T ist Euer Erfolg!

Die Herausgeber Martin Ebner und Sandra Schön

mit Jennifer Frey

Einführung

Dieser Beitrag stellt einen ersten Einstieg in das Themengebiet des Lernens und Lehrens mit Technologien dar. Was wird eigentlich darunter verstanden? Als zentrale Begriffe werden das technologiegestützte Lernen und Lehren (engl. ‚technology-enhanced learning‘), E-Learning sowie das Lernen mit neuen Medien erklärt. Auch wird in die pädagogischen Grundbegriffe aus dem Bereich des Lernens und Lehrens sowie in Lerntechnologien eingeführt. Weil das Themen- und Forschungsfeld des technologiegestützten Lernens und Lehrens interdisziplinär ist, werden die wichtigsten Zugänge vorgestellt. Die zunehmende Zahl an Lehrstühlen, Forschungseinrichtungen und Studiengängen werden als Indizien für eine Konsolidierung des Themenfelds als Forschungsgebiet interpretiert. Die gebotene Kürze verhindert eine ausführliche Diskussion, insbesondere der Grundbegriffe. Deshalb möchten wir darauf hinweisen, dass wir hier nur ausgewählte Zugänge und Meinungen präsentieren können.

Einleitung: Lernen und Lehren mit Technologien

Es gibt einige deutschsprachige Sammelwerke und Handbücher, die sich mit technologiegestütztem Lernen und Lehren beschäftigen: Das sind teils Einführungen zum Online-Lernen (Issing & Klimsa, 2008), Handbücher zum E-Learning (Hohenstein & Wilbers, 2002 mit laufenden Aktualisierungen; Kilian et al., 2011), aber auch Bücher mit starkem Praxisbezug, wie zum Beispiel „Innovative Lernsysteme“ (Kuhlmann & Sauter, 2008). Für Fachfremde nicht unmittelbar als Veröffentlichung in diesem Bereich erkennbar sind Bücher mit Titeln wie zum Beispiel das „CSCL-Kompendium“ (Haake et al., 2004) bzw. mittlerweile „CSCL-Kompendium 2.0“ (Haake et al., 2012). Allen diesen Werken gemeinsam ist, dass sie unterschiedliche Aspekte des Lernens und Lehrens mit Technologien behandeln.

Dieses Lehrbuch stellt das Unterfangen dar, das Themenfeld als Lerntexte für Studierende aufzubereiten. Wir haben dazu den Titel „Lehrbuch für Lernen und Lehren mit Technologien“ gewählt.

Nun fällt die Entscheidung für den Titel eines solchen Werkes nicht ad hoc. Genau genommen geht es weniger um sogenannte „Technologien“, worunter die „Wissenschaft zur Technik“ verstanden wird, sondern um Technik, also technische Geräte, vor allem um elektronische (und heute primär auch digitale) Geräte und Hilfsmittel. Wir hatten auch in Erwägung gezogen, im Lehrbuchtitel von „Technik“ zu sprechen. Im Themenfeld hat sich jedoch im deutschsprachigen Raum die Bezeichnung „Technologien“ durchgesetzt: Die englische Sprache dominiert hier die wissenschaftliche Kommunikation und kennt keine Unterscheidung zwischen „Technik“ und „Technologie“. In der internationalen, englischsprachigen Diskussion ist von „technologies“ die Rede. Auch im Deutschen spricht man heute selten vom – eigentlich korrekten – Lernen und Lehren mit Technik, sondern vom Lernen und Lehren mit Technologien.

!

Bevor Sie weiterlesen, haben wir eine Bitte an Sie: Bitte nehmen Sie sich kurz Zeit und formulieren Sie schriftlich, an welche Technologien Sie beim Lernen und Lehren mit Technologien denken.

Die Liste der Technologien, die beim Lernen und Lehren eingesetzt werden, ist lang und entwickelt sich ständig weiter. Es ist nicht trivial zu definieren, welche Technologien Lerntechnologien sind und welche nicht (Dror, 2008). Unter Lerntechnologien werden oft primär digitale Geräte und Anwendungen verstanden, welche zur Unterstützung des Lernens und Lehrens eingesetzt werden (Chan et al., 2006). Dazu zählen beispielsweise:

- Präsentationstechnologien wie der Tageslichtprojektor oder Diaprojektor,

- Kommunikationstechnologien wie Telefone oder Faxgeräte,

- Computertechnologien wie der Personal Computer und Laptops,

- Internettechnologien wie E-Mail und das World Wide Web sowie auch

- Sensortechnologien wie RFID (Radio-Frequency Identification), NFC (Near Field Communication) oder GPS (Global Positioning System) bei Mobiltelefonen.

!

Lernen und Lehren mit Technologien umfasst alle Lern- und Lehrprozesse sowie -handlungen, bei denen technische, vor allem elektronische (zumeist auch digitale) Geräte und Anwendungen verwendet werden. Ein besonderes, aber nicht ausschließliches Augenmerk liegt dabei auf Geräten und Anwendungen und den Informations- und Kommunikationstechnologien.

Grundbegriffe im Themenfeld

Was bedeuten Begriffe wie „technologiegestütztes Lernen“, „E-Learning“ oder „Lernen mit neuen Medien“? Erwartungsgemäß werden die zahlreichen Begriffe im Themenfeld variantenreich eingesetzt, dennoch entwickelte sich hier in den letzten zwanzig Jahren ein gewisser Konsens in der Verwendung der Begriffe und darüber, welche Technologien dabei im Einsatz sind.

„Technologiegestütztes Lernen“ bzw. „Technology-Enhanced Learning“

Erstes, nachstehendes, Element wird ans Ende der vorherigen Seite gestellt

Der Begriff des „Technology-Enhanced Learning“ beziehungsweise des „technologiegestützten Lernens“ (oder „technologisch gestützten Lernens“) ist der weitest gespannte Begriff, welcher jene Technologien umfasst, mit deren Hilfe Aktivitäten des Lernens unterstützt werden. Immer, wenn in einer Lern- oder Lehrsituation Technologien zum Einsatz kommen, kann vom technologiegestützten oder technologisch gestützten Lernen gesprochen werden (Dror, 2008). Dies ist beispielsweise also auch dann der Fall, wenn im Unterricht ein Film gezeigt wird oder ein Schulkind eine Klassenkameradin bzw. einen Klassenkameraden anruft, um Unterstützung bei der Hausaufgabe zu erhalten.

Der Begriff „E-Learning“

!

Der Begriff des E-Learning wird häufig dann verwendet, wenn Computer in Netzwerken (insbesondere des Internets) zum Einsatz kommen und diese Technologien die technische Basis für die Lern- und Lehrhandlungen bilden.

Der Begriff „E-Learning“ ist im Englischen wie im Deutschen geläufig. Das „E“ steht dabei, wie auch bei der „E-Mail“, als Abkürzung des Wortes „electronic“, also „elektronisch“. Wenn Forscher/innen und Praktiker/innen aus dem Bereich des technologiegestützten Lernens von ihrem Arbeitsfeld berichten, fällt häufig das Schlagwort „E-Learning“. Darunter wird jedoch nicht unbedingt Einheitliches verstanden.

Das erste Mal fiel der Begriff „E-Learning“ vermutlich mit der Einführung von ersten Computeranwendungen, die Lernende unterstützten, beispielsweise Programme zum trainieren des Wortschatzes. Diese ersten Computerlernprogramme (engl. „computer based training“, CBT) erlaubten keine Interaktion mit anderen Lernenden oder Lehrenden. Mit der Kommerzialisierung des aus dem Computernetzwerk des US-Verteidigungsministeriums (ARPANET, 1969) entstandenen Internets (1990) und der Einführung des World Wide Webs (1989) wurde nicht nur ein weltweiter Zugang zu solchen Angeboten, sondern auch die Interaktion und der Austausch mit anderen Nutzerinnen und Nutzern erst ermöglicht und gefördert: Während zunächst Selbstlernmaterialien im Vordergrund standen, entwickelten sich schnell interaktive Formate, wie beispielsweise virtuelle Seminare, also Lehrveranstaltungen, die im Wesentlichen auf textbasierter Kommunikation der Teilnehmerinnen und Teilnehmer beruhten.

So wird der Begriff E-Learning von einigen für das weite Feld von elektronischen Anwendungen, sei es das Telefon, der Videoprojektor oder Internet, verwendet; er deckt damit weitestgehend dasselbe Feld wie der obige Begriff des technologiegestützten Lernens ab (Kerres, 2001).

Häufiger wird der Begriff „E-Learning“ aber enger verwendet, nämlich für Lernsituationen, bei denen mit dem Computer und dem Internet gelernt wird. Wird hierbei von „E-Learning“ gesprochen, beschränkt sich das Verständnis häufig auf Lern- und Lehrsituationen des Fernunterrichts und des verteilten Lernens im Internet oder mit anderen vernetzten Geräten wie den Mobiltelefonen.

Lernen mit neuen Medien

Schließlich möchten wir in unserem Zusammenhang noch auf einen dritten Begriff eingehen; auf das Lernen und Lehren mit „neuen Medien“. „Medium“, aus dem Lateinischen abgeleitet, bedeutet „in der Mitte“ oder „Mittler“. Wenn also die Medienpädagogik oder die Medieninformatik über Medien spricht, dann sind Kanäle oder Systeme gemeint, über die Daten oder Informationen (sinnbezogene zusammenhängende Daten) gespeichert, übertragen oder vermittelt werden. Beispiele für Medien sind Massenmedien wie das Fernsehen oder das Radio sowie die traditionellen Printmedien wie Zeitungen und Bücher. Diese Medien sind das traditionelle Arbeitsgebiet der Medienpädagogik (siehe Kapitel #medienpaedagogik). Wenn von „neuen“ Medien die Rede ist, wird derzeit in der Regel auf das Internet und Webtechnologien Bezug genommen. Mit den Medienwissenschaften gibt es einen eigenen Zugang mit zahlreichen unterschiedlichen theoretischen Positionen, wie diese neuen Medien Gesellschaft gestalten und wie die Gesellschaft Medien gestaltet (siehe Kapitel #medientheorie).

Für die Medieninformatik ist die Sicht auf Medien übrigens nicht auf Massenmedien eingeschränkt (Malaka et al., 2009): Aus deren Sicht sind zum Beispiel Speichermedien wie die Festplatte des PC oder der USB-Stick ebenfalls als Medien anzuführen.

?

Deckt sich Ihr, bei der obigen Frage formuliertes, Verständnis vom Lernen und Lehren mit Technologien mit einem der drei Begriffe und deren Bezugstechnologien? Worin gibt es Übereinstimmungen, wo weicht Ihre Definition ab?

Vergleich der Begriffe

Wir haben versucht, die jeweiligen Technologien, die bei Verwendung der drei vorgestellten Begriffe „mitgedacht“ werden, in Abbildung 1 zu visualisieren. Das Verständnis der Begriffe ist jedoch nicht einheitlich.

Zusätzlich gibt es eine Reihe enger gefasster, also auf einige Technologien beschränkte Begriffe des technologiegestützten Lernens, wie beispielsweise das mobile Lernen mit Mobiltelefonen und anderen portablen Geräten (engl. „mobile learning“;m-Learning; siehe Kapitel #mobil) oder auch das Online-Lernen für das internet- bzw. intranetgestützte Fernlernen (siehe Kapitel #fernunterricht).

Auch gibt es Begriffe technologiegestützten Lernens, die nicht auf die Nutzung ausgewählter Technologien hinweisen. Vielfach wird im Bereich des technologiegestützten Lernens auf bestimmte Methoden abgezielt. So steht CSCL für das computergestützte kooperative Lernen (engl. „computer supported collaborative learning“). Damit haben wir auch aufgeklärt, worum es sich beim einführend erwähnten „CSCL-Kompendium“ handelt. Oder hatten Sie das gewusst?

Lernen und Lehren

Wir haben es bisher gewissermaßen vorausgesetzt, aber was ist das eigentlich, das „Lernen“ und das „Lehren“? Was wird darunter aus wissenschaftlicher Perspektive verstanden?

Lernen: umfassend und lebenslang

Erklärungen und Theorien zum Lernen werden vor allem in der Psychologie entwickelt und überprüft. Lernen wird dabei als eine Veränderung im Verhalten beschrieben. Aus Sicht der Psychologie ist das Lernen ein Prozess, der zu relativ stabilen Veränderungen im Verhalten oder im Verhaltenspotenzial führt und auf Erfahrung aufbaut, aber beispielsweise nicht auf Reifevorgänge oder Ermüdung zurückzuführen ist (Zimbardo & Gerrig, 1996, 206). Was gelernt wurde, ob es eine Verbesserung oder Verschlechterung des Verhaltens gibt, spielt dabei nach diesem Verständnis keine Rolle (Schaub & Zenke, 2004, 352): Veränderung kann dabei das Erlernen aber auch Verlernen beziehungsweise die Anpassung oder Fehlanpassung bedeuten. Menschen „lernen“ in diesem Sinne zum Beispiel durch Werbung möglicherweise ein anderes Kaufverhalten.

Beim technologiegestützten Lernen geht es jedoch in aller Regel nicht um „irgendein“ Lernen oder irgendeine Verhaltensänderung, sondern um konkrete Verbesserungen des Wissens, des Verhaltens und der Kompetenzen. Lernen soll hier dazu führen, sich bestmöglich zu entwickeln (Faulstich, 2005, 14). Normative Überlegungen spielen auch beim technologiegestützten Lernen eine wichtige Rolle: Was sollen die Lernenden, also Schülerinnen und Schüler, Studierende oder Arbeitnehmerinnen und Arbeitnehmer, lernen? In Bildungsprogrammen und Lehrplänen werden so konkrete Erziehungs- und Bildungsziele oder auch angestrebte „Schlüsselqualifikationen“ und Kompetenzen genannt (Tippelt & Schmidt, 2005).

!

Auch beim technologiegestützten Lernen werden Aktivitäten von Lernenden unterstützt, die in einer Verbesserung des Verhaltens (des Wissens, der Kompetenzen) resultieren.

In den letzten zehn Jahren wird häufig auf das sogenannte „informelle Lernen“ verwiesen. Es grenzt sich vom sogenannten „formalen Lernen“, also dem institutionell organisierten Lernen, ab und wird in der Regel für den gesamten Bereich des „nicht institutionell organisierten“ Lernens verwendet (Frank et al., 2005). Es gibt dabei jedoch auch hier eine Reihe unterschiedlicher Definitionen mit feinsinnigen Unterscheidungen (Dohmen, 2001). Im englischsprachigen Raum, maßgeblich durch ein Memorandum der Kommission der Europäischen Gemeinschaft (2000) bestärkt, ist sogar eine dreiteilige Unterscheidung gängig: „formal learning“, „non-formal learning“ und „informal learning“ (ebenda, 9). Nach diesem Verständnis wird unter „informellem Lernen“ das Lernen als „natürliche Begleiterscheinung des täglichen Lebens“, unter „non-formalem Lernen“ vor allem selbstgesteuertes Lernen (ebenda) verstanden.

Ein weiterer zentraler Lernbegriff in der Diskussion des technologiegestützten Lernens ist das sogenannte lebenslange Lernen (engl. „lifelong learning“). Darunter versteht man nicht die Einsicht, dass man lebenslang lernt, sondern die Motivation, dass man das ganze Leben lang lernen soll (Smith, 1996). Der Ausdruck „lifelong learning“ soll erstmals in dem von der sogenannten „Faure-Kommission“ im Auftrag der UNESCO verfassten Buch „Learning to be“ (Faure et al., 1972) verwendet worden sein (Knapper, 2001, 130). Auch hier ist die Kommission der Europäischen Gemeinschaft ein Treiber der Diskussion. Sie betonte in ihrem Memorandum im Jahr 2000, dass lebenslanges Lernen nicht nur über die zeitliche Lebensspanne der Menschen andauern, sondern gleichzeitig auch lebensumspannend sein soll (Europäische Kommission, 2000, 9) und initiierte ein gleichnamiges Forschungsprogramm („lifelong learning programme“).

Lehren: Unterricht und Didaktik

Bei denjenigen, die andere beim Lernen unterstützen, spricht man von Lehrenden und Unterrichtenden. Lehrende gibt es in allen Bildungsbereichen, beispielsweise Erziehungs-, Lehr- und Ausbildungspersonal, in Betrieben und Berufsschulen sowie auch in großer Zahl in der Erwachsenenbildung. Lehrende werden dann dort auch als Coach, Trainer/in, Tutor/in, Dozent/in manchmal auch als Berater/in bezeichnet.

Was gute Lehre, guten Unterricht ausmacht, ist Gegenstand der Didaktik. Unterschiedliche Traditionen konkurrieren hier ebenso wie auch begriffliche Abgrenzungen. So hat Comenius im 17. Jahrhundert den Begriff ‚Didaktik‘ in Abgrenzung zur ‚Mathetik‘, der Lehre des Lernens verstanden (Comenius, 1983). Heute wird Didaktik nach Klafki als eher theoretische Begründung des konkreten pädagogischen Handelns, des Wissens über das „wie?“, kurz zur „Methodik“ gesehen (Klafki, 1991).

Was gute Lehre ist, wird von unterschiedlichen Teildisziplinen und Richtungen unterschiedlich beantwortet. So werden didaktische Empfehlungen häufig auf (einzelnen) Lerntheorien und entsprechenden Erkenntnissen der pädagogischen Psychologie aufgebaut (siehe Kapitel #lerntheorie). Aber auch aus bildungstheoretischen Überlegungen, die Menschen ‚als Ganzes‘ in ihrer Persönlichkeit begreifen und sie bei ihrer Entwicklung ihrer Persönlichkeit unterstützen wollen, werden Ableitungen für guten Unterricht erstellt.

Technologien im Unterricht wirken sich auf die Methodik wie die Didaktik aus. Bei der Methode ‚Frontalunterricht‘ konnten so, ergänzend zum Tafelbild und Kartenmaterial, beispielsweise durch Diaprojektoren Fotos im Unterricht vorgeführt werden. Mit zunehmender Integration von Technologien wie dem computer- und webgestützten Lernen können Technologien nicht mehr nur ‚als Ergänzung‘ betrachtet werden, sondern werden mit ihren Gestaltungs- und Einsatzmöglichkeiten selbst ein wichtiges Element didaktischer und methodischer Überlegungen sowie Entscheidungen. Beispielsweise eröffnen sie neue Spielräume für differenzierten, also auf unterschiedliche Bedürfnisse der Lernenden abgestimmten, Unterricht oder auch für neue Formen der Zusammenarbeit: Das gleichzeitige gemeinsame Schreiben eines Textes ist auf herkömmliche Weise, auf dem Papier, kaum möglich.

Szenarien des Einsatzes von Technologien

Ein kurzer Rückblick

Erstes, nachstehendes, Element wird ans Ende der vorherigen Seite gestellt

Noch vor wenigen Jahrzehnten waren Technologien Unterrichtsmittel, die den Lehrenden im Fern- und Präsenzunterricht entlasten und ersetzen sollten. Mit dem sogenannten ‚programmierten Lernen‘ wurden ‚Lernmaschinen‘ entwickelt, die den Lehrenden unterstützten sollten. In einer damaligen Darstellung heißt es dazu (Wilden, 1965, 98): „Lehrermangel und überaltete Lernformen scheinen der Forderung recht zu geben, wenigstens die Übungs- und Wiederholungsvorgänge Maschinen zu überlassen, die den didaktischen Gesamtvorgang in Einzelschritte zerlegen […] Ein Lernprogramm führt auch bei Versagen des Schülers mit Hilfe mechanischer Vorgänge und Auslösungen zu erneuter Übung und Erfassung von Teilvorgängen, schließlich zum Lernerfolg“. In den letzten Jahrzehnten hat sich durch die Computer- und Internettechnologie und die damit verbundenen Kommunikationsformen vieles getan. So gibt es weiterhin eine Reihe von Einsatzmöglichkeiten, die Lehrende entlasten.

Ein wesentliches Merkmal webbasierter Anwendungen sind aber nun Kommunikation und Kollaboration. Die entsprechenden Anwendungen eröffnen dadurch für Lernende und Lehrende vor allem solche neuen Wege des gemeinsamen Lernens.

?

Sie haben bereits auf vielfältige Weise gelernt und waren eventuell auch als Lehrende bzw. Lehrender im Einsatz. Sammeln Sie für sich oder in der Gruppe einige Beispiele, wie dabei Technologien eingesetzt wurden.

Online-Lernen, Blended Learning und MOOCs

Heute gibt es zahlreiche unterschiedliche Formen des Einsatzes von Technologien im Unterricht. In reinen Online-Lernsituationen werden zum Beispiel Lernmaterialien im Internet zur Verfügung gestellt, über digitale Kommunikationswege (Forum, Chat, Soziale Netzwerke …) diskutiert oder E-Mails mit Tutorinnen und Tutoren ausgetauscht. Der einzelne Lernende sitzt dabei also alleine am Computer oder einem anderen „Endgerät“, lernt aber nicht notwendigerweise isoliert, sondern im intensiven Austausch mit anderen Lernenden und Lehrenden. Im Vergleich zu Präsenzveranstaltungen ermöglicht reines Online-Lernen, außerhalb der üblichen Seminarzeiten und zu eigens festgelegten bzw. selbstbestimmten Zeiten zu lernen. Gleichzeitig aber fordert der, im Vergleich zum Präsenzunterricht, unverbindliche Charakter einer solchen Lernsituation große Motivation und Selbstdisziplin seitens der Lernenden. Manchmal werden durch das Lernen über das World Wide Web auch Szenarien möglich, die mit realen Treffen nicht oder schwer zu organisieren und zu finanzieren wären: Online-Veranstaltungen mit Teilnehmenden aus der ganzen Welt, zum Beispiel Muttersprachler/inn/en, die auf einer Sprachlernplattform Unterstützung geben.

In der Praxis werden Online-Phasen und Präsenzunterricht häufig kombiniert beziehungsweise abgewechselt. Man spricht dann vom „Blended Learning“ (auf Deutsch „gemischtes Lernen“). Blended-Learning-Szenarien werden aus unterschiedlichen Motiven eingesetzt. Den Präsenzunterricht ergänzende Online-Phasen werden als Möglichkeit gesehen, das individuelle, selbstorganisierte und arbeitsplatznahe Lernen zu begleiten und zu unterstützen. Auch wird durch Online-Phasen das Lernen aus dem Seminarraum in die Arbeits- und Lebenswelt der Lernenden hinausgetragen; der Transfer des Gelernten gelingt unter Umständen leichter. Schlussendlich wird Online-Unterricht auch eingesetzt, um oft teureren Präsenzunterricht zu sparen.

Spätestens seit Herbst 2011 hat sich in der Diskussion um Online-Lehre ein weiterer Begriff Aufmerksamkeit verdient: MOOC, kurz für Massive Open Online Course. Als ein MOOC wird eine spezielle Form der reinen Online-Lehre bezeichnet, deren Hauptmerkmale eine sehr große Anzahl an Lernenden, und ein freier Online-Zugang zu den Lehr- und Lernunterlagen sind. Der Begriff geht auf Dave Cormier zurück, der 2008 einen Online-Kurs bei George Siemens und Stephen Downes besucht (McAuley, 2010). Während diese Veranstaltungen stark dem Konnektivismus nach Siemens (siehe Kapitel #lerntheorie) folgten, startete die Universität Stanford 2011 drei Online-Kurse mit je über 100.000 registrierten Teilnehmenden und prägte das Bild von MOOCs, welches heute durch die Medien propagiert wird: Auf einer Plattform zur Verfügung gestellte Inhalte (vorwiegend Videos) mit anschließenden Überprüfungen und vergleichsweise geringer Interaktion zwischen Lehrenden und Lernenden. Diese führte dazu, dass im Wissenschaftsbereich heute zwei Arten von MOOCs unterschieden werden, cMOOC (connectivist MOOC) und xMOOC (Extension MOOC) (Wedekind, 2013) (siehe Kapitel #systeme #lll #offeneslernen).

Zahlreiche Mischformen: Die Barbecue-Typologie

Im Bildungsalltag gibt es nicht immer und ausschließlich reine Präsenzphasen ohne Technologieeinsatz oder reine Online-Phasen. Technologien, insbesondere webbasierte Werkzeuge und Systeme, werden auch im Präsenzunterricht eingesetzt, zum Beispiel, wenn mit dem Internet recherchiert wird. Auch werden in Schulen und insbesondere Hochschulen häufig webbasierte Lernmanagementsysteme eingesetzt (siehe Kapitel #systeme, #infosysteme #schule #hochschule). Lernende erhalten dort ergänzende Materialien, zum Beispiel Präsentationsunterlagen, führen dort unterrichtsbegleitende Diskussionen oder finden dort Lernaufgaben, deren Lösungen wiederum über das System den Lehrenden zugänglich gemacht werden.

Vielfältige Lernsituationen mit Technologien sind bekannt, ohne dass sich dafür Bezeichnungen durchgesetzt haben. Wir haben versucht, ein geeignetes Bild zu finden, um die unterschiedlichen Formen anschaulich zu beschreiben. Mit einem Augenzwinkern machen wir uns das Bild der Grillwurst und ihrer unterschiedlichen Zubereitungsformen zu eigen und nennen die Darstellung folglich Barbecue-Typologie des Lernen und Lehrens mit Technologien:

- Wie in Abbildung 2 dargestellt, wird der traditionelle, „technologiefreie“ Präsenzunterricht mit einer Bratwurst verglichen. Manche mögen sie pur.

- Präsenzunterricht kann durch den Einsatz von Technologien angereichert werden (z.B.: Verwendung eines Overhead-Projektors #ipad). Bildlich dargestellt durch Senf- oder Ketchup-Kleckse.

- In Schulen und Hochschulen wird der Präsenzunterricht durch die Lernmanagementsysteme kontinuierlich begleitet sowie durch weiteren Technologieeinsatz erweitert. Im Bild wird die Bratwurst, der pure Präsenzunterricht, von einem Brötchen umgeben und in Senf beziehungsweise Ketchup gebettet. Es ergibt sich ein Hot Dog.

- Wechseln sich Phasen des Online-Lernens mit Präsenzphasen ab (das „Blended Learning“), lässt sich das mit einem Schaschlik-Spieß visualisieren, auf dem sich Wurstscheiben (Präsenzphasen) mit Gemüse (Online-Phasen) abwechseln.

- Und weil es auch Arrangements ohne Präsenzunterricht gibt, also bildlich gesprochen keine Wurst vorhanden ist, wird reines Online-Lernen schlussendlich mit einem Gemüsespieß dargestellt.

Wie beim Grillen sind schließlich beim Einsatz von Technologien weitere zahlreiche Kombinationen möglich. Die einzelnen Möglichkeiten sind dabei ohne Wertigkeit zu sehen; die Entscheidung, was gut passt und besser schmeckt, ist den Lernenden und Lehrenden zu überlassen.

!

Allgemein gibt es keine „guten“ oder „besseren“ Formen des Technologieeinsatzes und des Wechsels von Online- und Präsenzphasen. Die Entscheidung, was gut passt und besser schmeckt, ist den Lernenden und Lehrenden zu überlassen.

Diskussion: „E-Learning 2.0“

Ein Schlagwort, um welches man nicht herumkommt, auch wenn es langsam an Resonanz verliert, ist der Begriff „Web 2.0“. Das Web 2.0 hat das Lernen und die Vorstellung darüber, wie gelernt werden kann, stark beeinflusst und beflügelt.

Web 2.0

Der Begriff „Web 2.0“ soll auf Scott Dietzen, einen ehemaligen Mitarbeiter bei Bea Systems, zurückgehen und wurde erstmalig im Dezember 2003 in der US-Ausgabe „Fast Forward 2010 – The Fate of IT“ des CIO-Magazins von Eric Knorr in der Öffentlichkeit verwendet (Knorr, 2003). Mit der ersten Web-2.0-Konferenz im Herbst 2004 in San Francisco, veranstaltet von Tim O’Reilly (gemeinsam mit Dale Dougherty), erlangte der Begriff den internationalen Durchbruch. 2005 wird er in einem Artikel auch von O’Reilly (2005) benannt. Er definierte das Web 2.0 dabei nicht als eine ‚neue Technologie‘, sondern eine neue Art, eine neue Haltung (engl. ‚attitude‘), wie Menschen mit dem Internet umgehen. Internetnutzer/innen sind nicht mehr bloß Lesende statischer Webseiten, sondern können diese oftmals modifizieren, ohne dass hierzu Kenntnisse von zusätzlichen Programmiersprachen nötig wären. Zu Beginn des World Wide Web kam man nicht darum herum, die dafür notwendigen HTML-Kenntnisse zu erlernen (siehe Kapitel #hypertext, #fernunterricht). Die Weiterentwicklung von Internettechnologien und entsprechend einfachen Benutzeroberflächen macht es nun vergleichsweise einfach, sich zu beteiligen: Selbsterstellte Mediendateien wie Fotografien oder Tonaufnahmen können unter anderem über gemeinsame Plattformen im Internet zur Verfügung gestellt werden; man tauscht sich mit Schul- und Arbeitslkolleg/inn/en in sozialen Netzwerken aus.

Die für die Entwicklung notwendigen Internettechnologien (siehe Kapitel #webtech) traten bei der Debatte über „Web 2.0“ per Definition (O’Reilly, 2005) in den Hintergrund. Dies erklärt auch, dass man beim Versuch, das Web 2.0 an einzelnen Entwicklungen dingfest zu machen, unweigerlich auf ein anwachsendes Sammelsurium an Möglichkeiten stößt, denen allen aber gemeinsam ist, dass der Fokus auf Interaktion (Kommunikation, Arbeiten, Teilen) der Benutzenden liegt, unabhängig von einzelnen Programmiersprachen und Plattformen.

Das Web der Inhaltskonsumierenden wurde zu einem Web von miteinander kommunizierenden Inhaltsproduzierenden. Weil nun jede und jeder (relativ) einfach mitgestalten und mitmachen kann, wird es auch gerne als „Mitmach-Web“ bezeichnet. Gerade diese Vereinfachung und Potenzierung des Gemeinschaftlichen unterstreicht die Bezeichnung des Web 2.0 als ‚soziale‘ und weniger ‚technische Revolution‘ (Downes, 2005). Man spricht darüber hinaus auch von der kollektiven Intelligenz (O'Reilly, 2005), von der Weisheit der Vielen (Surowiecki, 2005) und von der ‚Kultur der Amateure‘ (Keen, 2007). Das TIME Magazine griff diese Entwicklung frühzeitig auf, indem es im Jahr 2006 „You – the Internet User“ zur Person des Jahres kürte (Grossman, 2006).

!

1989 träumt Tim Berners-Lee, der als einer der Vordenker des World Wide Web gilt (siehe #www), von einem Internet, in und über welches alle mit allen alles teilen können (Berners-Lee, 1989); mit dem ‚Web 2.0‘ ist dieser Traum ein Stück mehr Realität geworden.

Trotz der eher „nicht-technischen“ Charakterisierung des Web 2.0 gibt es Typen von Anwendungen, die als Web-2.0-Anwendungen beschrieben werden. Wir stellen sie hier kurz vor:

-

Wikis sind Content-Management-Systeme (CMS) und bestehen aus Webseiten, deren Inhalte von mehreren Benutzerinnen und Benutzern gemeinsam (kollaborativ), aber nicht gleichzeitig bearbeitet werden können. Kennzeichnend für Wikis sind die integrierte Versionskontrolle und die Linkkonsistenz. Wikis werden oft als Wissenskompendien eingesetzt (siehe Kapitel #kollaboration).

-

Weblogs sind Webseiten mit mehr oder weniger regelmäßig neu erscheinenden Einträgen, chronologisch mit dem neuesten beginnend sortiert. Den Strom an Artikeln eines Weblogs (engl. „stream“) können Leserinnen und Leser kommentieren. Jeder Artikel ist über einen eigenen gleichbleibenden Link (permanenter Link) auf anderen Webseiten verknüpfbar. Microblogging-Systeme, die nur kurze Nachrichten mit maximal 140 Zeichen unterstützen, allen voran Twitter, haben in den letzten Jahren an Popularität gewonnen (siehe Kapitel #blogging).

-